Voiceflow夏休みAdvent Calendarの9日目です。すいません、ちょっと遅れましたので、この週末にキャッチアップ予定・・・

まずは小ネタから。

Voiceflowは、APLにも対応していますので、画面付きデバイス向けにビジュアルも付与したスキルを作成することができます。ただし、当然のことながら画面なしデバイスには画面出力ができませんので、スキル側できちんと画面の有無をチェックしてあげる必要があります。

公式からもTIPSが紹介されています。

これ、英語で、かつ、ちょっとわかりにくいところもあるので、少しわかりやすく修正して、かつ、画面付きスキルの場合は実際に画面表示を行ってみたいと思います。

スキルの全体図

ざっくりでいうと、

- 最初のCode BlockでAPL対応かどうかのチェックを行うコードを書く

- If Blockでその結果をもとに分岐

- 対応の場合はDisplay Blockで画面出力するとともに、対応していることをしゃべる

- 非対応の場合は、画面表示をせずに、非対応であることをしゃべる

って感じです。一つづつ見ていきます。

変数の作成

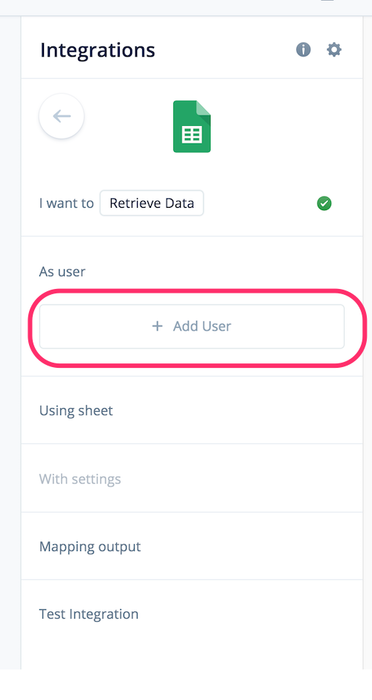

最初に、Code Blockで取得したAPL対応チェックの結果を入れておくための変数を作成します。ここではフロー変数で"hasDisplay"としました。

Code Block

ここでAPL対応かどうかをチェックします。以下のコードを入力します。

if (voiceflow.capabilities && ('Alexa.Presentation.APL' in voiceflow.capabilities)) {

hasDisplay = 1;

} else {

hasDisplay = 0;

}

voiceflow.capabilitiesというのは、Voiceflowが持っているビルトインの変数というかオブジェクトです。この中に、今使っているデバイスがどういう機能をサポートしているかの情報が入ってます。APL対応機種、すなわち、画面付きデバイスの場合は Alexa.Presentation.APL というオブジェクトが入ってくるのでこれがあるかどうかをチェックするというわけですね。API対応していれば 1 、非対応であれば 0がhasDisplayに入ります。

(ここ、少し公式の書き方を変えてます。公式の書き方だと、If Blockの設定でハマるケース多そうなので、シンプルな数値比較でできるようにしました。)

If Block

ここで、先程のhasDisplayで分岐させます。

hasDisplayが1ならば画面付きのフローに進みます。それ以外は画面なしのフローに進みます。

Display Block

APLの画面表示にはDisplay Blockを使います。実際にサンプルを設定してみましょう。Display Blockをクリックして"Add Displays"をクリックします。

"New Display"をクリックします。

APLのテンプレートを登録する画面が表示されます。ここでAPLのJSONを書いて登録することになるのですが、アレを1から書くのは正気の沙汰ではないのでツールの力を借りましょう、"Authoring Tool"をクリックしてください。

はい、スキル開発されたことのある方ならば一度は見たことがある、Alexa開発者コンソールにあるAPLオーサリングツールが表示されます。APLについてはさすがにVoiceflow側でもインタフェースはまだできてないということですね。なので、ここでAPLのテンプレートを作成して、JSONファイルダウンロードして、Voiceflow側でインポートするというのが、VoiceflowでのAPL設定の流れとなります。 今回はテストなので、予め用意してあるサンプルのテンプレートを使ってみましょう。「画面表示サンプル」をクリックします。

サンプルのテンプレートが表示されます。画面下部にあるダウンロードっぽいアイコンをクリックして、コードを書き出します。

するとapl_template_export.json というファイルがダウンロードされます。Voiceflow側に戻って、"Upload JSON File"をクリック、先程のapl_template_export.jsonを選択してアップロードします。

アップロードが完了すると、画面下部にAPLのJSONが表示されます。今回は特に修正しません。Display NameでAPLテンプレートの名前、Display Descriptionでテンプレートの説明メモを設定できます。今回は変更しませんが、適宜設定してください。終わったら右上のSaveで保存して、左上のCanvasをクリックしてフロー画面に戻ります。

フロー画面に戻ったら、Display Blockをクリックします。右側のメニューが最初とは変わっていることに気づくと思います。"Select Multimodal Display" のドロップダウンをひらいてみてください。

すると先程のAPLテンプレートが選べるようになっています。今回は特にテンプレート名を指定しなかったので"New Display"となっています。名前を指定した場合はその名前が表示されるかと思いますので、これを選択します。

こんな感じで、APLのJSONが表示されればOKです。これでDisplay Blockの設定は完了です。

Speak Block

ここは難しくないので割愛します。画面付きと画面なしで喋る内容を変えているだけなので、以下のキャプチャを御覧ください。

テスト

ではテストです。Alexa 開発者コンソールであればAPLのテストもできます。

画面が表示されていますね! APL非対応の場合のテストは実機でやってみました。(っていうか開発者コンソールでそういうのできないのかな・・・)

ちゃんとチェック結果で振り分けられていることがわかるかと思います。

ということで、APLことはじめ、な感じもあったので長くなったのですが、チェック自体は簡単にできます。ぜひご活用ください。